Новая DeepSeek V3: рекорды в бенчах, кодинг лучше Claude и GPT-4.5

Позавчера DeepSeek загадочно и молчаливо залили новую модель на HuggingFace, даже не написав ничего не в блоге, ни в README файле.

Сегодня, наконец, вышел анонс с подробным описанием характеристик новой модели (а точнее, крутого обновления старой модели). Давайте разбираться, что в этот раз нам подогнали китайские исследователи.

Количественно

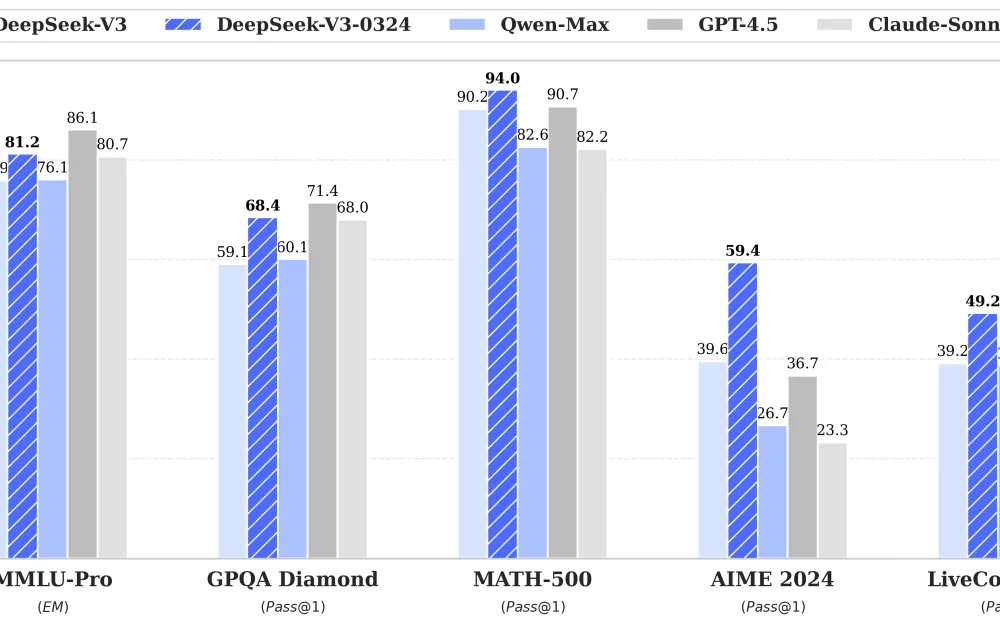

В первую очередь, давайте посмотрим на результаты бенчей по математике и программированию:

MMLU-Pro: вырос с 75.9 → 81.2 (+5.3)

GPQA: вырос с 59.1 → 68.4 (+9.3)

AIME: вырос с 39.6 → 59.4 (+19.8) (вау, SOTA, с сильным отрывом)

LiveCodeBench: 39.2 → 49.2 (+10.0)

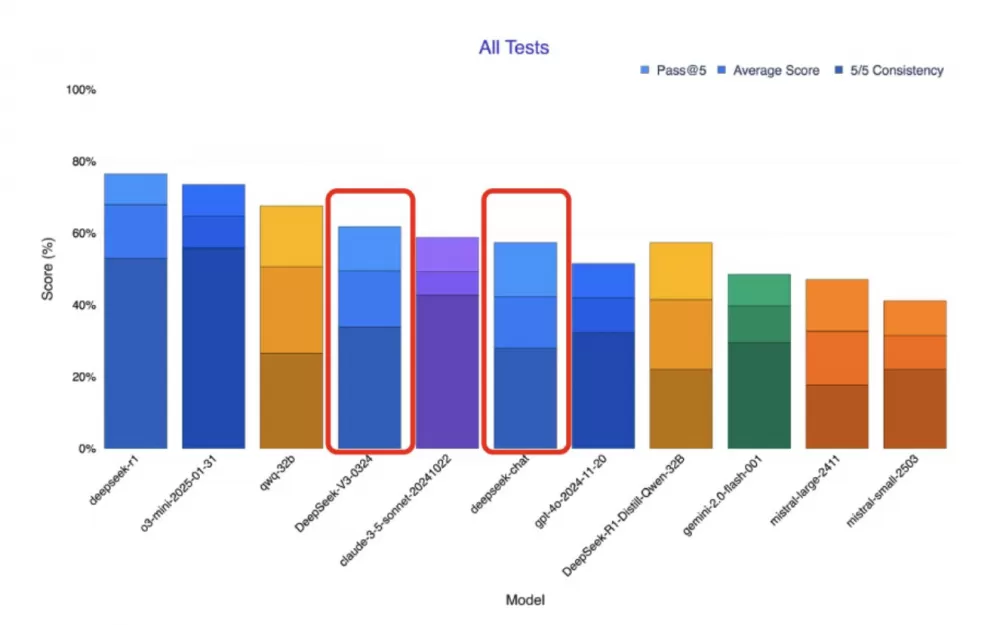

В усреднённых результатах по всех тестам мы видим, что V3-0324 обгоняет текущие результаты Claude 3.5 (в целом, 3.5 - старая модель, ничего удивительного). Claude 3.7 почему-то в этих тестах вообще не измерялся.

Интересно, что в заявлениях по бенчам самого DeepSeek - они обгоняют 3.7. Из-за чего в интернете даже разгорелись жаркие споры, а не был ли V3-0324 обучен на Claude 3.7.

Однозначного вердикта нет, разные пользователи считают по разному, многие считают, что заявления о "краже" 3.7 во многом политические, и Anthropic таким образом в очередной раз пытаются вставить палки в колёса Китаю.

С другой стороны, назвать их безосновательными сложно - китайские модели уже не раз "ловили за руку" на обучении на диалогах моделей OpenAI. Учитывая, что в моделях для разработки лидирует Claude, было бы неудивительно, если бы для "программистской" модели они решили дистиллировать ответы Claude 3.7.

Другие обновления

Авторы подсвечивают, что модель прокачалась во фронтенде, разработке веб-интерфейсов:

Улучшение исполняемости кода (то есть написание без ошибок)

Более эстетически привлекательные веб-страницы и игровые интерфейсы

Улучшилось качество Function Calling - вызова кастомных инструментов, предоставленных модели.

Помимо этого, из коробки есть хорошая заточка на чтение контента файлов и обработки результатов веб-поиска - явный заход на территорию агентских систем, будет очень интересно потестировать V3-0324 в Курсоре.

(Если улучшился китайский, но нам это не особо важно)

Многие исследователи говорят, что модель хорошо запускается на Mac Studio, выдавая 20 токенов в секунду. Это довольно медленно, но запуск модели такого масштаба локально (пусть и на весьма дорогой машине) - это, конечно, крайне впечатляющий результат.

И то, что модель подобной мощности и объема выложена в паблик - это тоже, конечно, удивительно здорово.

P.S. Я очень много пишу про разработку c ИИ у себя в телеграм-канале. Заставляю ИИ писать хороший код, обозреваю свежие новости технологий, а ещё публикую эти самые новости раньше всех. Регулярно даю глубокую аналитику по отрасли и всем событиям, и рассказываю как создавать собственных ИИ-агентов и приложения с ИИ (и как раз на днях потестирую эту V3-0324). А ещё недавно стал выкладывать подобные обзоры на ютуб. Велком!

Написать комментарий