Вышла Qwen QwQ 32B — размышляющая модель, сопоставимая с DeepSeek R1 и o1-mini

Китайская команда Qwen выпустила размышляющую модель QwQ-32B с открытой лицензией Apache 2.0.

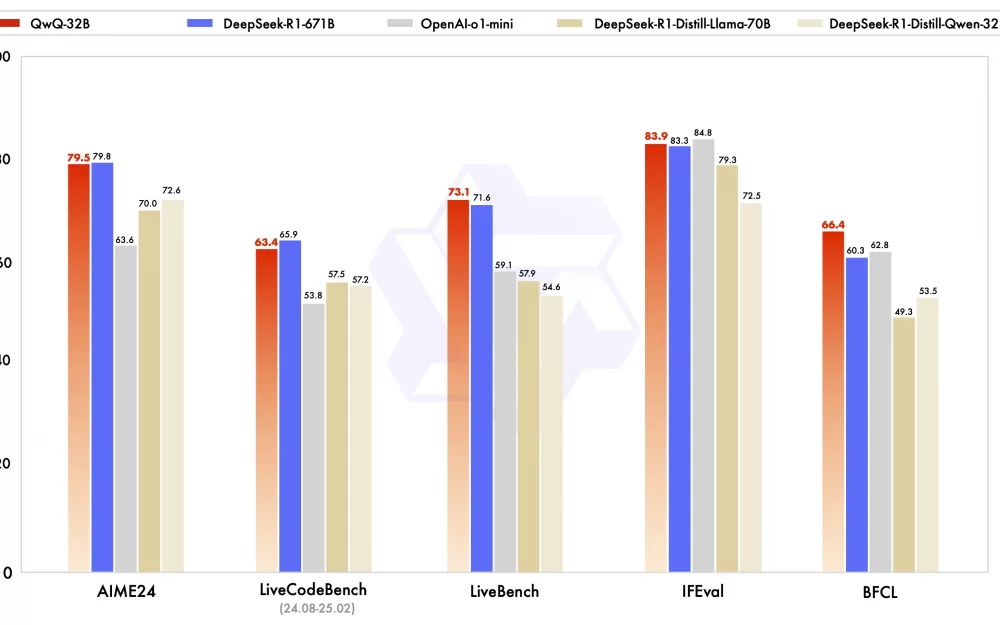

Несмотря на небольшой размер в 32B, модель по метрикам сопоставима с гигантской DeepSeek R1 671B. Также модель значительно обгоняет так называемые дистилляты: DeepSeek-R1-LLama-70B (обученная на размышлениях Llama 70B) и DeepSeek-R1-Qwen-32B (обученная на размышлениях Qwen 32B)

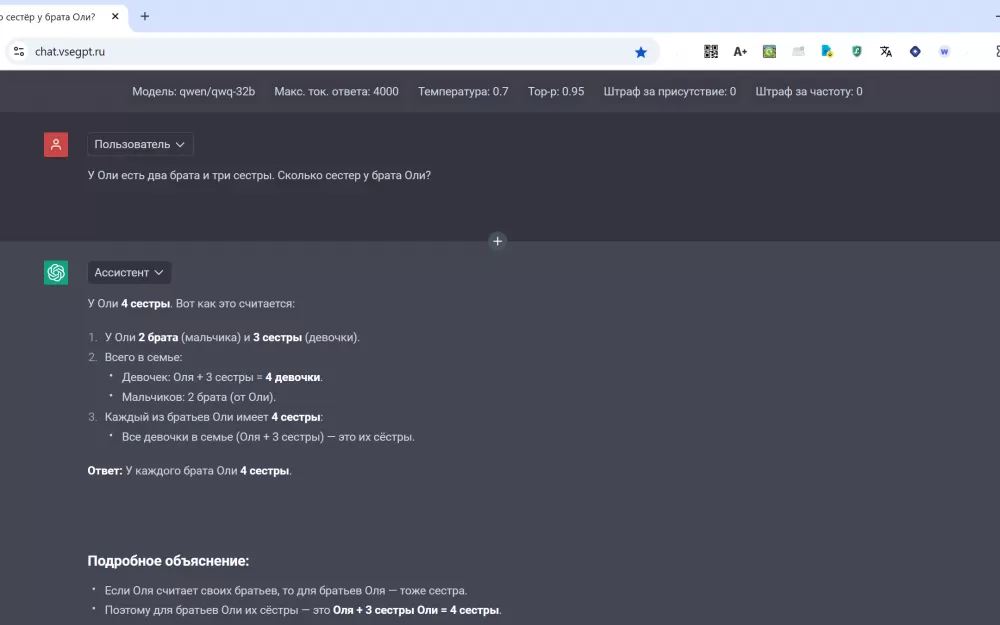

Согласно проведенным экспериментам, модель неплохо отвечает на русском языке. Также она корректно решила вопросы "с подвохом", на которые обычно некорректно отвечают нейросетевые модели без рассуждений, и которые часто используются в тестах:

Что больше - 3.11 или 3.9?

У Оли есть два брата и три сестры. Сколько сестер у брата Оли?

В целом, модель выглядит очень интересно - 32B модель в принципе можно запустить на домашней машине с приличной скоростью, в отличие от сильной, но гигантской DeepSeek R1 671B.

Написать комментарий