Языковые модели могут перегружать себя мыслями и застревать в бесконечных циклах мыслей

Новое исследование выявило неожиданную слабость языковых моделей: они могут зацикливаться на мышлении вместо действия, особенно в интерактивных средах. Эта тенденция к чрезмерному размышлению может значительно повредить их производительности, даже несмотря на то, что эти модели специально разработаны для рассуждений. Исследователи из нескольких университетов США и ETH Zurich разработали методы для измерения и решения этой проблемы в интерактивных сценариях, называемых «агентными задачами».

В этих задачах модели AI должны самостоятельно преследовать цели, использовать интерфейсы на естественном языке и производить структурированные результаты для работы с другими инструментами. Модели должны собирать, хранить и действовать на основе информации автономно.

Исследовательская группа выявила то, что они называют «дилеммой рассуждения-действия». Модели AI должны постоянно балансировать между прямым взаимодействием с окружающей средой для получения обратной связи и внутренним моделированием для рассмотрения возможных действий и последствий.

Исследователи обнаружили, что даже при неограниченной вычислительной мощности модели искусственного интеллекта, которые слишком много думают, все равно принимают плохие решения. Это происходит из-за того, что модели не полностью понимают мир, что приводит к ошибкам, которые со временем усугубляются.

Они создали систематический способ измерения избыточного мышления с использованием двух ключевых фреймворков: бенчмарка по программной инженерии "SWE-bench Verified" и фреймворка "OpenHands Framework" для моделирования интерактивных сред. Они использовали большое контекстное окно Claude 3.5 Sonnet на 200 000 токенов для анализа примерно 4 000 процессов взаимодействия, оценивая избыточное мышление по шкале от 0 до 10.

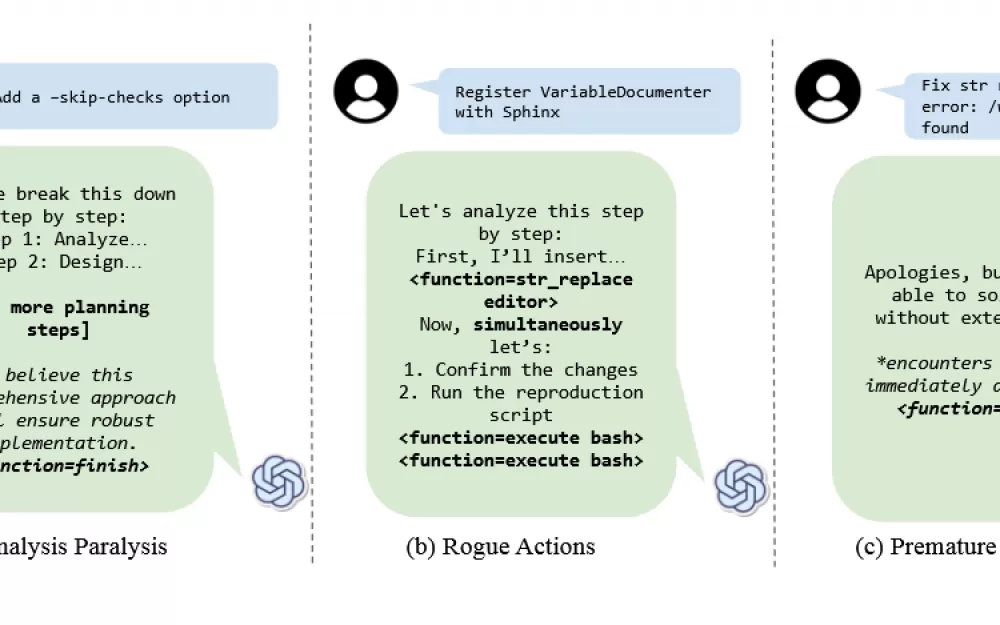

Анализ выявил три основные модели проблемного поведения. Во-первых, модели испытывали аналитический паралич, застревая на этапе планирования. Во-вторых, они совершали неконтролируемые действия, пытаясь выполнить несколько действий одновременно вместо того, чтобы следовать необходимым последовательным шагам. В-третьих, они преждевременно отключались, отказываясь от задач, основанных на внутренних симуляциях, без проверки результатов в реальной среде.

Последние два поведения — нечестные действия и преждевременное отстранение — интересным образом связаны с «недодумыванием», которое другая исследовательская группа недавно обнаружила в моделях рассуждений. В то время как то исследование показало, что модели AI иногда думают слишком мало и дают ответы более низкого качества, это новое исследование показывает противоположную проблему: модели также могут застревать, думая слишком много, что приводит к низкой производительности.

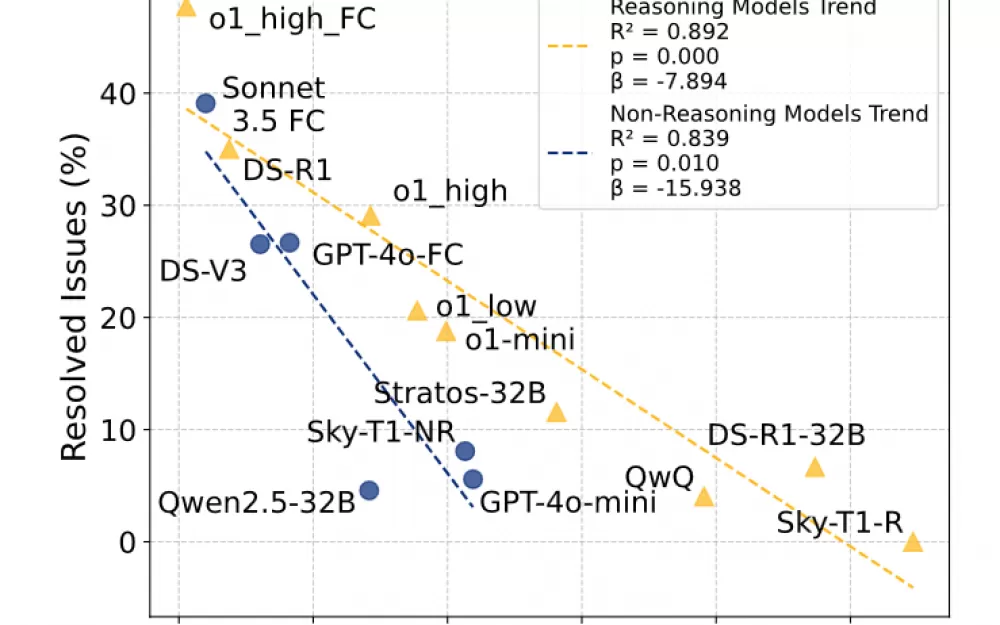

В исследовании рассматривались 19 различных языковых моделей, включая o1 от OpenAI, QwQ от Alibaba и DeepSeek-R1. Исследователи обнаружили, что как рассуждающие, так и нерассуждающие модели, такие как Claude 3.5 Sonnet и GPT-4o, демонстрировали тенденции к чрезмерному мышлению, хотя рассуждающие модели имели более высокие показатели чрезмерного думания.

Влияние было более серьезным для нерассуждающих моделей, которые не были обучены обрабатывать расширенные мыслительные процессы. Меньшие модели оказались более восприимчивыми к переосмыслению, вероятно, потому, что им было трудно обрабатывать сложность окружающей среды. Возможно, удивительно, но исследователи обнаружили, что размер контекстного окна модели — сколько информации она могла обработать одновременно — мало влиял на ее тенденцию к переосмыслению.

Исследование показывает, что даже базовые вмешательства могут снизить излишнее обдумывание и улучшить производительность модели. Генерируя несколько быстрых решений и выбирая то, которое требует меньше всего излишнего обдумывания, они повысили скорость принятия решений на 25%, одновременно снизив затраты на вычисления на 43%.

Модели с собственным вызовом функций продемонстрировали значительно меньше излишних размышлений и заметно лучшую производительность.

Удивительно, но особенно крупная модель DeepSeek-R1-671B не продемонстрировала повышенного уровня чрезмерного мышления, что исследователи связывают с процессом ее обучения, а именно с отсутствием обучения с подкреплением для задач по разработке программного обеспечения.

Источник

Написать комментарий