Сэм Альтман заявил, что объединение LLM и LRM может принести новые научные знания

Обучение все более крупных языковых моделей с использованием все большего количества данных заходит в тупик. По словам генерального директора OpenAI Сэма Альтмана, объединение «гораздо больших» предварительно обученных моделей с возможностями рассуждения может стать ключом к преодолению ограничений масштабирования предварительного обучения.

Предварительно обученные языковые модели больше не масштабируются так эффективно, как раньше, и эта точка зрения, похоже, получила широкое признание в индустрии ИИ. Теперь Альтман называет предварительное обучение «старым миром».

Вместо этого OpenAI изучает специализированные модели, оптимизированные с помощью обучения с подкреплением для задач с четкими правильными или неправильными ответами, такими как программирование и математика. Компания называет их «большими моделями рассуждений» или LRM , наиболее значительным развитием в этой области за последний год, говорит Альтман.

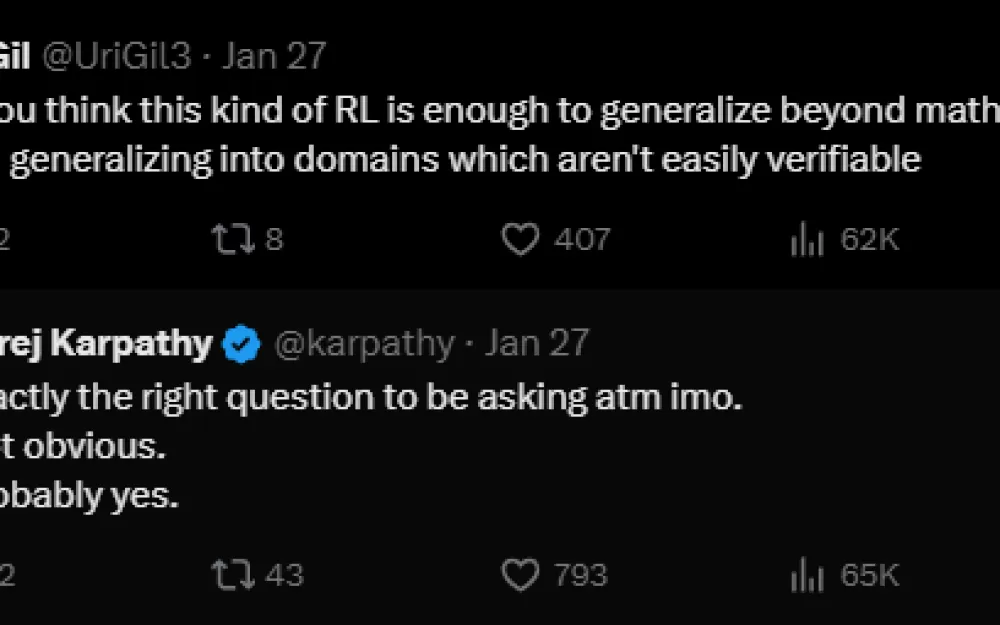

Главный вопрос сейчас заключается в том, возможно ли объединить широкие возможности LLM со специализированной точностью LRM.

По словам Альтмана, модели рассуждений обеспечивают невероятный новый прирост эффективности вычислений, а OpenAI может достичь производительности во многих тестах, которую в «старом мире» мы бы предсказывали только в GPT 6» с «моделями, которые намного меньше».

Проблема, отметил Альтман, заключается в том, что «когда мы делаем это по-новому, не все становится лучше. Мы можем добиться улучшения в определенных измерениях».

По словам Альтмана, сочетание предварительной подготовки «гораздо большей модели» и ее объединения с возможностями рассуждения может принести «первые крупицы или своего рода признаки жизни в области подлинно нового научного знания».

Их последняя модель может невероятно хорошо программировать, но не так хороша для изобретения совершенно новых алгоритмов или новой физики, или новой биологии.

Он приводит прогресс в программировании в качестве примера быстрого прогресса посредством обучения с подкреплением: их первая модель рассуждений o1 была оценена как лучший миллионный конкурентоспособный программист в мире. К декабрю их модель o3 стала 175-м лучшим конкурентоспособным программистом в мире. Внутреннее тестирование теперь показывает приблизительно 50-е место, и Альтман считает, что «может быть, мы достигнем первого места к концу этого года».

Альтман повторил намерение OpenAI вернуться к практикам открытого исходного кода , хотя он остался характерно неопределенным относительно деталей. «Мы собираемся это сделать», сказал Альтман, и что, похоже, «общество готово пойти на компромиссы, по крайней мере, на данный момент».

Он добавляет, что OpenAI достигла значительного прогресса в разработке безопасных и надежных моделей, подходящих для приложений с открытым исходным кодом. Хотя эти модели не всегда используются по назначению, большую часть времени они работают так, как задумано, говорит Альтман, не уточняя, какие именно модели или когда они могут быть выпущены.

Обсуждение приобрело новую актуальность после того, как китайская компания Deepseek выпустила свою модель рассуждений R1 с открытым исходным кодом, достигнув производительности, схожей с моделью o1 OpenAI. Этот шаг заставил некоторых усомниться в более ограничительном подходе OpenAI, который компания обосновала необходимостью предотвращения ненадлежащего использования.

Источник

Написать комментарий