Семейство моделей Gemini 2.0 от Google пополнилось Flash-Lite и Pro

Google расширяет семейство моделей искусственного интеллекта тремя новыми вариантами Gemini 2.0, каждый из которых предназначен для различных вариантов использования и предлагает разный баланс производительности и стоимости.

Базовая модель Gemini 2.0 Flash, представленная в декабре , теперь доступна всем желающим с более высокими ограничениями скорости и улучшенной производительностью, сообщает Google. Google также запускает Gemini 2.0 Flash-Lite, экономичный вариант для разработчиков, который в настоящее время находится в публичной предварительной версии через API.

Завершает линейку Gemini 2.0 Pro, которую Google описывает как все еще экспериментальную. Разработанная для сложных запросов и задач программирования, она имеет расширенное контекстное окно в 2 миллиона токенов — вдвое больше, чем у версий Flash. Хотя на данный момент модели поддерживают только текстовый вывод, Google планирует добавить возможности изображений и аудио, а также живое видео в Flash и Pro в ближайшие месяцы. Все три модели могут обрабатывать изображения и аудио в качестве входных данных.

Google также тестирует модели Flash Thinking с Gemini 2.0 , которые работают аналогично OpenAI o3 и Deepseek-R1, выполняя дополнительные шаги рассуждения перед генерацией ответов. Эти модели могут получать доступ к YouTube, Картам и Поиску Google. Примечательно, что в анонсе отсутствует флагманская модель "Gemini 2.0 Ultra".

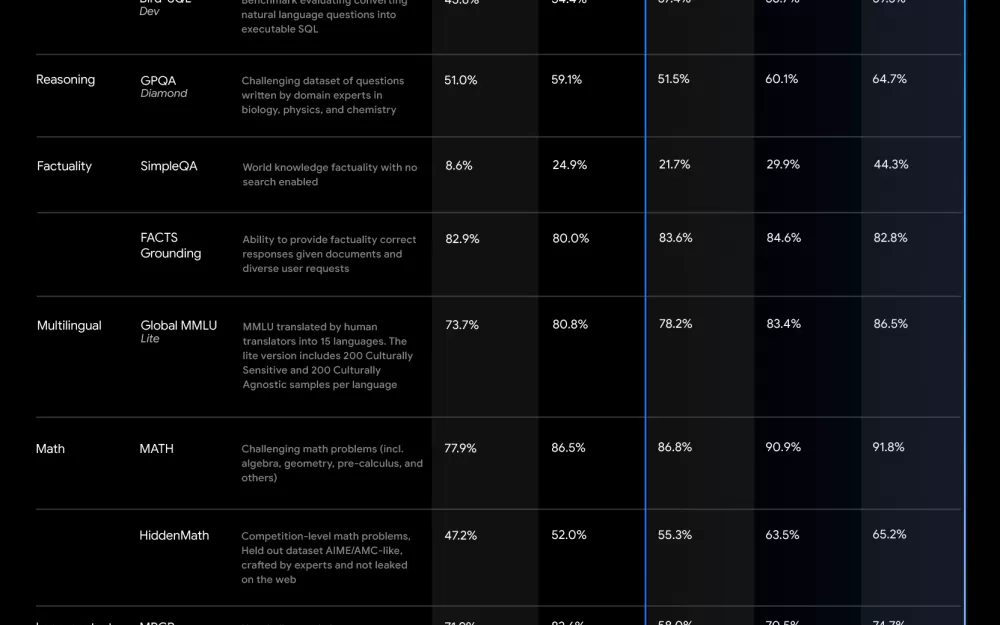

Данные бенчмарков Google показывают, что Gemini 2.0 Pro превосходит своих предшественников почти во всех областях. Для математических задач он набирает 91,8% в тесте MATH и 65,2% в HiddenMath, значительно превосходя варианты Flash. Общая версия Flash 2.0 набирает промежуточные баллы между Flash Lite и Pro и превосходит старую модель 1.5 Pro.

В тесте SimpleQA OpenAI модель Pro достигла 44,3%, а Gemini 2.0 Flash — 29,9%. Deepseek-R1 (30,1%) и o3-mini-high (13,8%) значительно отстают в этом тесте, вероятно, из-за меньших наборов данных для обучения. Тест требует, чтобы модели отвечали на сложные фактические вопросы без доступа в интернет — хотя это может быть менее актуальным для реальных приложений.

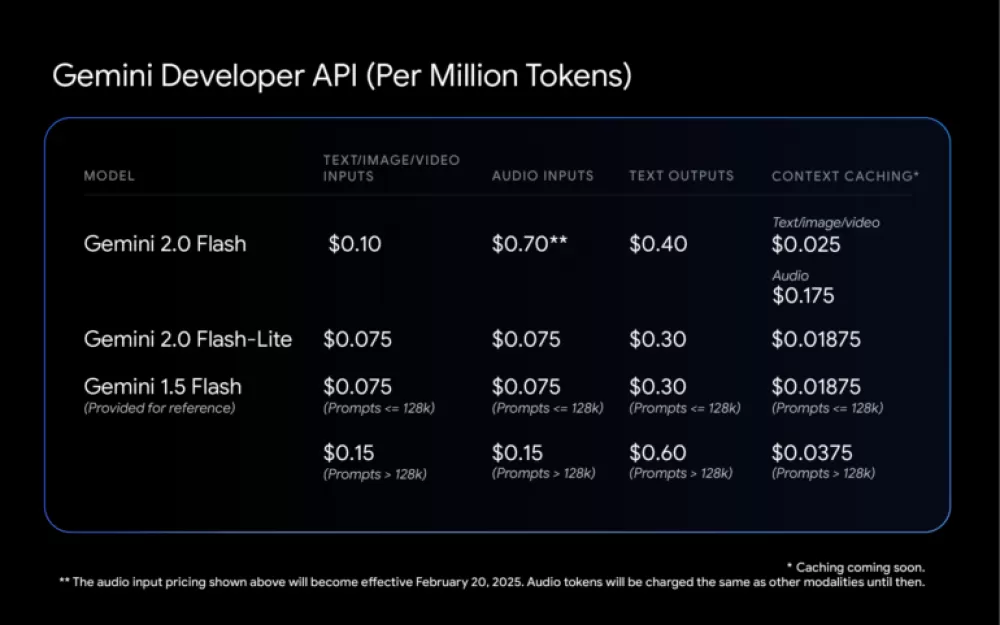

Для ценообразования API Google убрала прежнее различие между короткими и длинными контекстными запросами. Это означает, что смешанные рабочие нагрузки (текст и изображения) могут стоить меньше, чем с Gemini 1.5 Flash, несмотря на улучшения производительности.

В целом Gemini 2.0 Flash дороже своего предшественника. Однако новый Flash-Lite разработан для конкуренции со старым 1.5 Flash — он стоит столько же и работает лучше в большинстве тестов. Только реальные тесты покажут, обеспечивают ли две модели сопоставимое качество.

Все модели доступны через Google AI Studio и Vertex AI, а также через премиум чат-бот Gemini Advanced от Google на компьютерах и мобильных устройствах.

Источник

Написать комментарий