Исследователи MIT и Google повышают качество AI-генерируемых изображений без переобучения

Группа исследователей из Нью-Йоркского университета, Массачусетского технологического института и Google нашла способ улучшить изображения, генерируемые AI, заимствуя идеи из последних моделей рассуждений AI, таких как o1 от OpenAI.

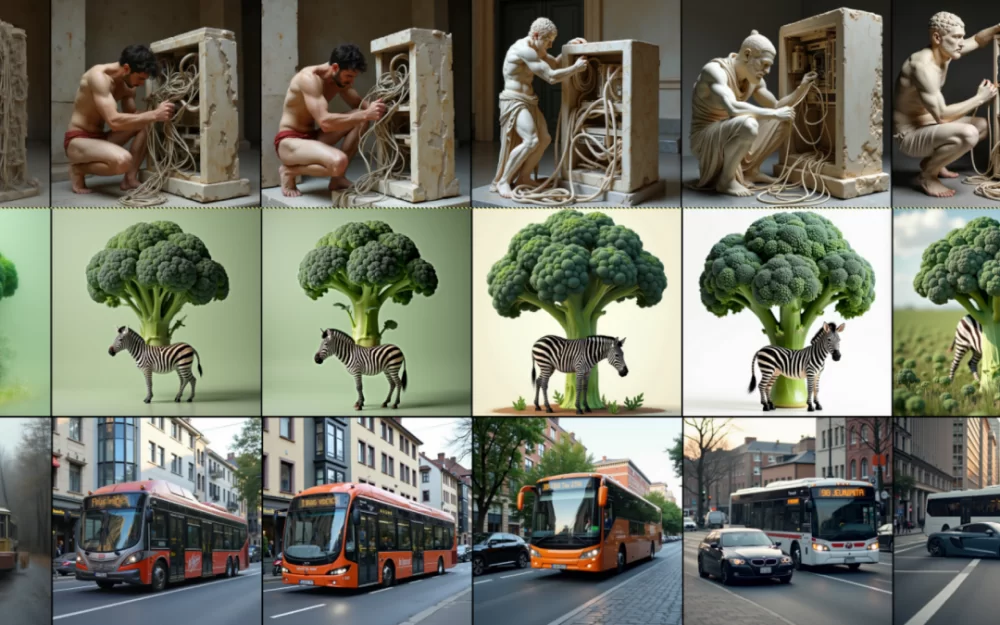

Их подход повышает качество изображения в процессе генерации, основываясь на том, как модели диффузии уже улучшают изображения с помощью шагов шумоподавления. В своей статье «Inference-Time Scaling for Diffusion Models beyond Scaling Denoising Steps» исследователи представляют два ключевых компонента: верификаторы, которые действуют как контролеры качества, и алгоритмы поиска, которые используют эти оценки качества для поиска лучших изображений.

Этот подход интересен тем, что он улучшает результаты без переобучения модели AI — вместо этого он оптимизирует сам процесс генерации, подобно тому, как такие модели, как o1 от OpenAI , Gemini 2.0 Flash Thinking от Google и R1 от DeepSeek , совершенствуют свои выходные данные при генерации текста.

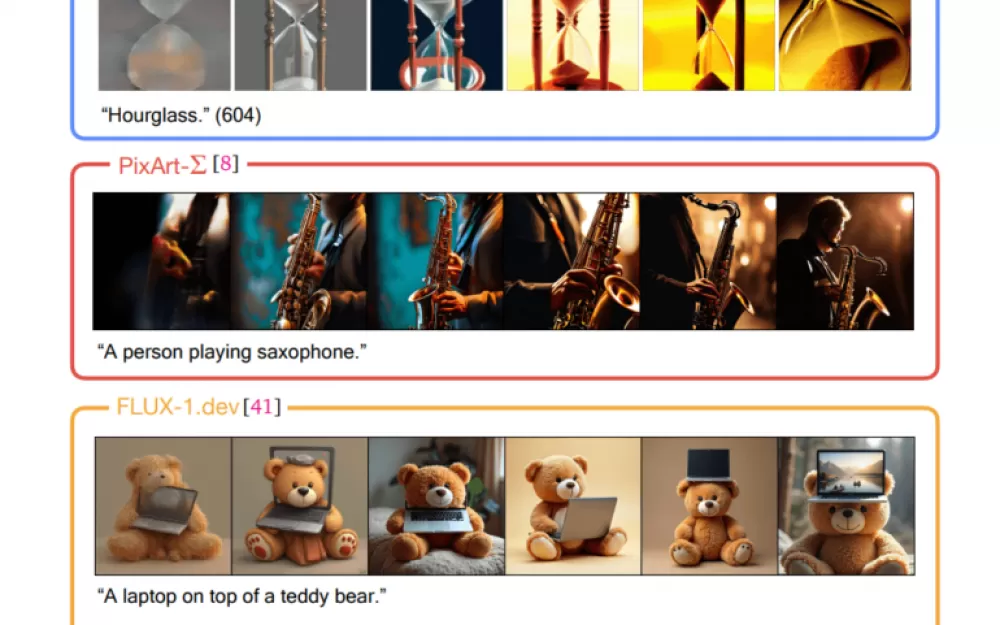

Система использует несколько типов верификаторов для оценки различных аспектов каждого сгенерированного изображения. К ним относятся эстетическая оценка визуального качества, «CLIPScore», проверяющий, насколько хорошо изображение соответствует текстовой подсказке, и «ImageReward», оценивающий изображения на основе человеческих критериев. Исследователи объединили этих оценщиков в «ансамбль верификаторов», чтобы учитывать несколько факторов качества одновременно.

Команда разработала три алгоритма поиска: Случайный поиск генерирует несколько версий и выбирает лучшую, хотя слишком много попыток могут привести к слишком похожим изображениям. Поиск нулевого порядка начинается со случайного изображения и систематически ищет улучшения поблизости. Поиск по путям, наиболее сложный подход, оптимизирует весь процесс генерации, улучшая различные шаги шумоподавления по ходу дела.

Тестирование показало, что все три метода значительно улучшили качество изображения — даже меньшие модели с этой оптимизацией превзошли более крупные модели без нее. Однако есть компромисс: более качественные изображения требуют больше вычислительного времени. Исследователи обнаружили, что около 50 дополнительных вычислительных шагов на изображение обеспечивают хороший баланс между качеством и скоростью.

Различные верификаторы показали различные результаты: Aesthetic Score имеет тенденцию создавать более художественные изображения, в то время как CLIPScore отдает предпочтение реалистичным. Это означает, что пользователи должны сами выбирать верификатор, на основе того, какой результат им нужен.

Источник

Написать комментарий