Apple начала начала сканировать с помощью ИИ локальные пользовательские фотографии на предмет достопримечательностей

Apple без предупреждения начала сканировать локальные пользовательские фотографии на предмет достопримечательностей и интересных мест на устройствах своих клиентов. Эта функция называется Enhanced Visual Search и впервые появилась в iOS 18.1 и macOS 15.1. Она включена по умолчанию, по-видимому, без явного согласия. Режим Enhanced Visual Search можно отключить в настройках вручную.

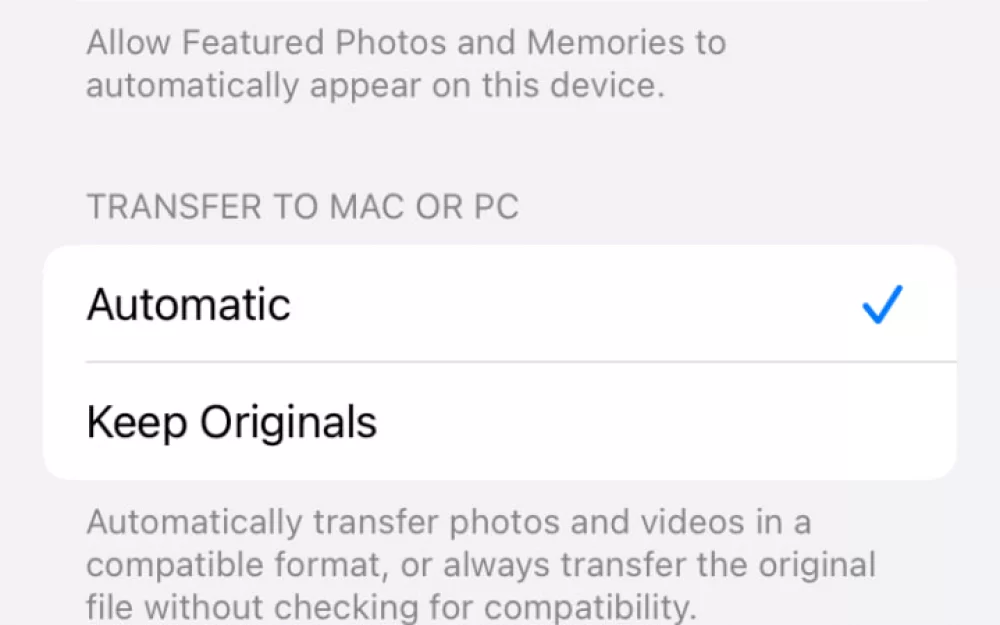

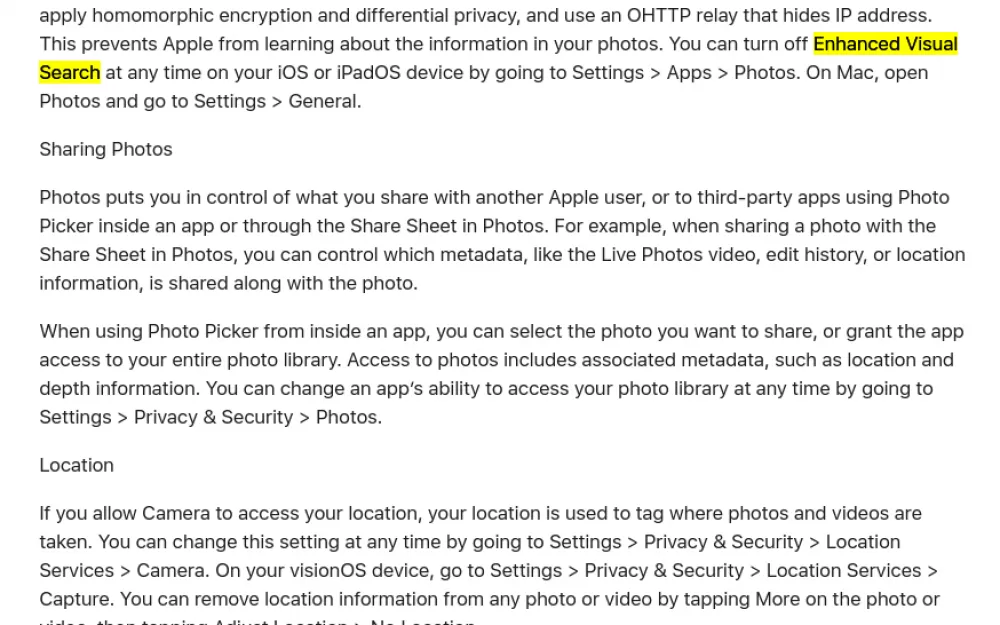

Согласно пояснению Apple, опция Enhanced Visual Searchлокально и конфиденциально сопоставляет места на фотографиях пользователя с глобальным индексом, который Apple ведёт на своих серверах. «Мы применяем гомоморфное шифрование и дифференциальную конфиденциальность (differential privacy), а также используем ретранслятор OHTTP Cloudflare, который скрывает ваш IP‑адрес. Это не позволяет Apple узнать информацию на ваших фотографиях. Вы можете отключить Enhanced Visual Search в любое время на вашем устройстве iOS или iPadOS, перейдя в Настройки → Приложения → Фотографии. На Mac откройте Photos и перейдите в Настройки → Общие», уточнили в Apple.

Профильные эксперты пояснили, что локальная модель машинного обучения Apple анализирует фотографии, чтобы найти «область интереса», которая может изображать достопримечательность. Если ИИ-модель находит вероятное совпадение, она вычисляет векторное встраивание — массив чисел — представляющий эту часть изображения.

Затем устройство (iPhone или Mac) использует гомоморфное шифрование таким образом, чтобы его можно было запустить через тщательно разработанные алгоритмы, которые выдают одинаково зашифрованный вывод. Цель заключается в том, чтобы зашифрованные данные можно было отправить в удаленную систему для анализа, не давая тому, кто управляет этой системой, знать содержимое этих данных. У Apple есть возможность выполнять вычисления c данными, но их результат остается зашифрованным. Входные и выходные данные зашифрованы сквозным шифрованием и не расшифровываются во время математических операций, как утверждается в компании.

В итоге серверы Apple получают гомоморфно зашифрованные данные, чтобы найти соответствие ориентиру в своей базе данных и вернуть результат на клиентское устройство, не предоставляя идентифицирующую информацию Apple или её партнеру OHTTP Cloudflare.

Таким образом, Apple в одностороннем порядке начала пропускать фотографии людей через локально работающий алгоритм машинного обучения, который анализирует детали изображения (на чисто визуальной основе, без использования данных о местоположении) и создает значение, связанное с тем, что может быть ориентиром на каждой фотографии. Затем это значение используется на удаленном сервере для проверки индекса таких значений, хранящихся на серверах Apple, чтобы помечать в каждом снимке ориентиры и места, найденные в базе данных Apple.

Проще говоря: вы делаете фотографию, ваш Mac или iPhone локально выделяет то, что, по его мнению, является ориентиром или интересным местом на снимке, гомоморфно шифрует представление этой части изображения таким образом, что его можно анализировать без расшифровки, отправляет зашифрованные данные на удаленный сервер для проведения этого анализа, чтобы ориентир можно было идентифицировать из большой базы данных мест, а потом устройство снова получает предложенное местоположение в зашифрованном виде, которое он один может расшифровать.

Если все работает так, как заявлено, и нет никаких побочных каналов или других утечек, Apple не может видеть, что находится на ваших фотографиях, ни данные изображения, ни искомую метку. Apple утверждает, что использование этого гомоморфного шифрования плюс так называемой дифференциальной конфиденциальности — способа защиты конфиденциальности людей, чьи данные появляются в наборе данных — исключает потенциальные проблемы конфиденциальности.

Написать комментарий