Функция Deep Research в ChatGPT обновляется и становится общедоступной

Компания OpenAI расширила функцию «Deep Research» для всех пользователей ChatGPT Plus, Team, Education и Enterprise, внеся некоторые улучшения с момента первоначального выпуска.

По словам компании, теперь эта функция встраивает изображения с информацией об источнике в результаты поиска и лучше «понимает и ссылается» на загруженные файлы.

Кроме того, пользователи Team, Enterprise и Education будут получать 10 запросов для углублённого анализа в месяц, а пользователи Pro получат доступ к 120 запросам.

Функция, которая впервые была представлена пользователям Pro в начале февраля, выполняет поиск по многочисленным онлайн-источникам и на их основе генерирует подробные отчёты, хотя в ней всё ещё есть ошибки, характерные для языковых моделей.

OpenAI опубликовал системную карту, в которой изложены сведения о разработке, возможностях и оценке рисков Deep Research, включая показатель риска галлюцинаций — случаев, когда модель генерирует ложную информацию.

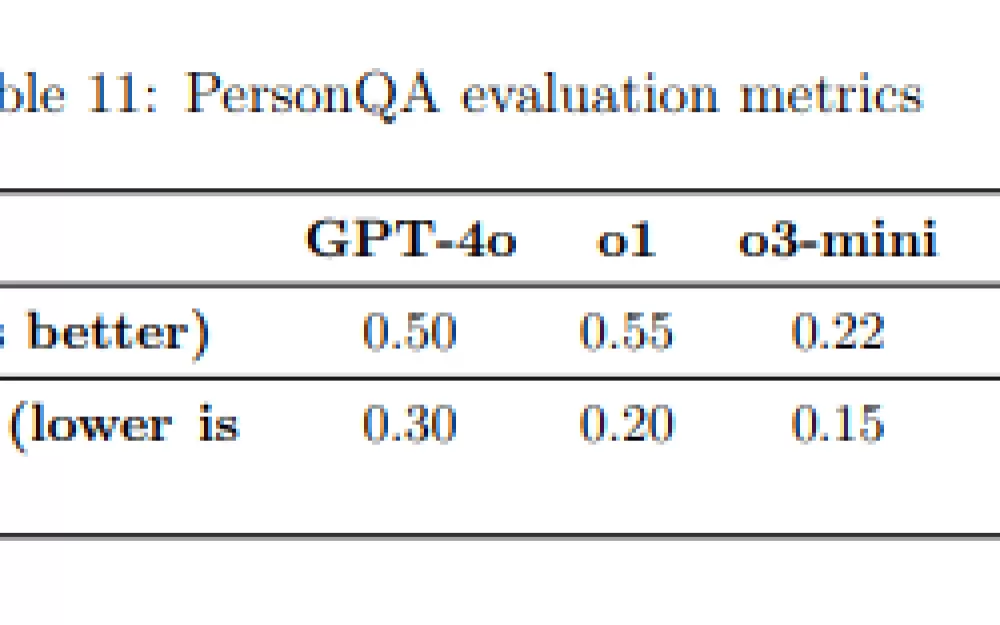

Тестирование с использованием набора данных PersonQA показывает значительное повышение точности. Deep Research достигла точности 0,86, что значительно лучше, чем GPT-4o (0,50), o1 (0,55) и o3-mini (0,22).

Частота галлюцинаций снизилась до 0,13, что лучше, чем у GPT-4o (0,30), o1 (0,20) и o3-mini (0,15). OpenAI отмечает, что эта частота может завышать реальные показатели галлюцинаций, поскольку некоторые якобы неправильные ответы основаны на устаревших тестовых данных. Компания заявляет, что обширные онлайн-исследования помогают сократить количество ошибок, а «процедуры после обучения» поощряют фактическую точность и препятствуют ложным утверждениям.

Однако 13-процентная частота ошибок всё равно означает, что пользователи могут столкнуться с многочисленными неточностями в более длинных исследовательских отчётах. Это по-прежнему важно учитывать при использовании инструмента — Deep Research наиболее эффективен для общих, хорошо задокументированных тем с проверенными источниками или при использовании экспертами в предметной области, которые могут быстро проверить сгенерированный контент.

Важно подчеркнуть, что неточности в работе ИИ, которые могут быть скрыты в, казалось бы, правильном и законном контексте, например, несколько ошибок, разбросанных по хорошо организованному, обширному и детальному отчёту, могут быть трудно обнаружимы, как хорошо известно OpenAI.

Источник

Написать комментарий