AI-ассистенты не проходят базовую проверку фактов в исследовании BBC

Оценка ведущих чат-ботов с AI выявила широкомасштабные проблемы с точностью и надежностью при работе с новостным контентом. В исследовании, проведенном BBC, были протестированы ChatGPT, Microsoft Copilot, Google Gemini и Perplexity на их способность точно сообщать о текущих событиях.

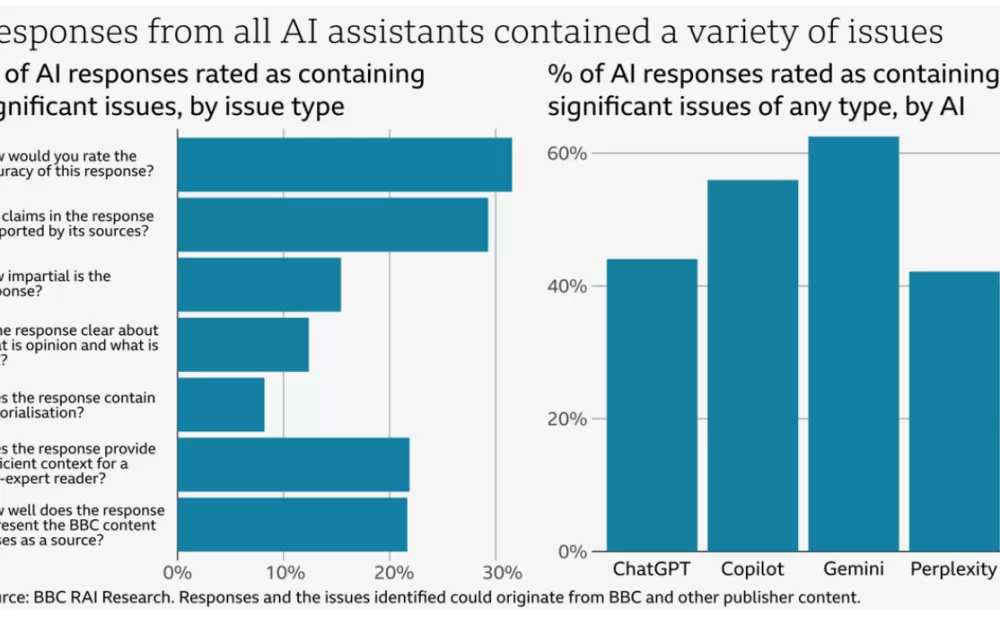

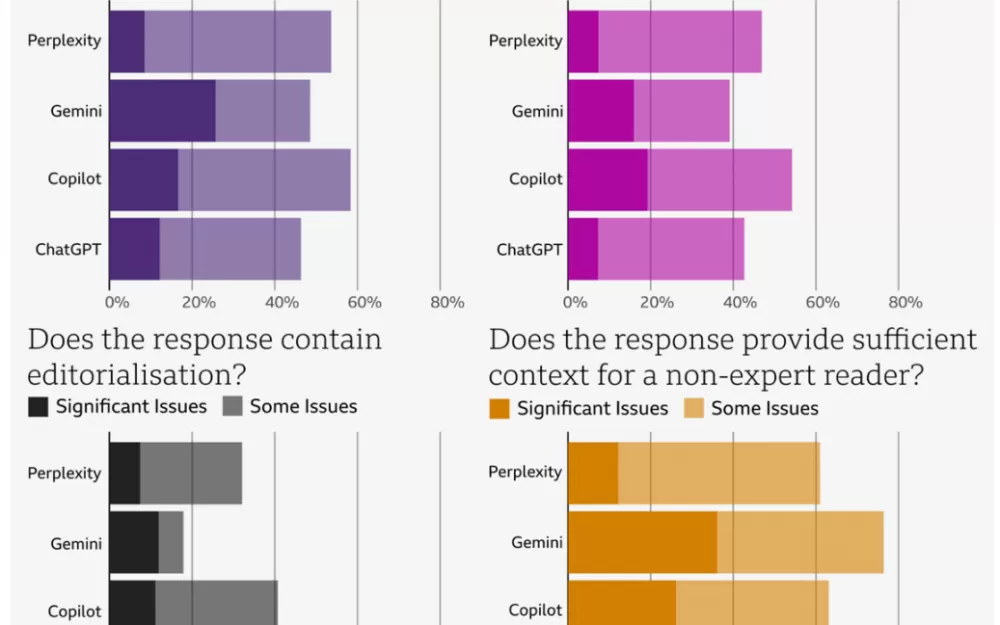

В декабре 2024 года 45 журналистов BBC оценили, как эти AI-системы справляются со 100 актуальными новостными вопросами. Они проанализировали ответы по семи ключевым параметрам: точность, приписывание источников, беспристрастность, разделение фактов и мнений, комментарии, контекст и правильное использование контента BBC. Каждый ответ оценивался от «нет проблем» до «значительные проблемы».

51% ответов AI содержали значительные проблемы — от базовых ошибок в фактчекинге до полностью сфабрикованной информации. Когда системы специально ссылались на контент BBC, 19% ответов содержали ошибки, а 13% содержали либо сфабрикованные, либо неправильно приписанные цитаты.

Некоторые из ошибок могли иметь последствия в реальном мире. Google Gemini неверно утверждал, что Национальная служба здравоохранения Великобритании (NHS) не рекомендует вейпинг, тогда как на самом деле данная организация рекомендует электронные сигареты для помощи людям в отказе от курения. Perplexity AI сфабриковал детали о смерти научного журналиста Майкла Мосли, в то время как ChatGPT не признал смерть лидера Хамаса, описывая его как действующего лидера через несколько месяцев после его кончины.

AI-ассистенты регулярно представляли устаревшую информацию как текущие новости, не разделяли мнения и факты и опускали важный контекст в своих сообщениях. Например, Microsoft Copilot представил статью 2022 года о независимости Шотландии как текущую новость.

BBC установила высокую планку в своей оценке — даже небольшие ошибки считались «значительными проблемами», если они могли ввести в заблуждение читателя. И хотя стандарты были жесткими, обнаруженные проблемы соответствуют тому, что другие исследователи уже замечали о том, как AI "спотыкается" при работе с новостями.

Возьмем один из самых поразительных примеров: чат-бот Bing от Microsoft настолько запутался при чтении судебного освещения, что обвинил журналиста в совершении тех самых преступлений, о которых он сообщал.

BBC заявляет, что повторит это исследование в ближайшем будущем. Привлечение независимых рецензентов и сравнение того, как часто люди совершают подобные ошибки, могут сделать будущие исследования еще более полезными — это помогло бы показать, насколько велика разница между работой человека и AI.

BBC признает, что их исследование, хотя и раскрывает проблему, лишь начинает выяснять ее полный масштаб. Отслеживание этих ошибок представляет сложную задачу. «Масштаб и объем ошибок и искажения доверенного контента неизвестны», — говорится в отчете BBC.

AI-ассистенты могут предоставить ответы на практически неограниченный диапазон вопросов, и разные пользователи могут получить совершенно разные ответы на один и тот же вопрос. Эта непоследовательность делает систематическую оценку чрезвычайно сложной.

Проблема выходит за рамки пользователей и журналистов. Медиа-компании и регуляторы не имеют инструментов для полного мониторинга или измерения этих искажений. Возможно, наиболее тревожно то, что BBC предполагает, что даже сами компании, разрабатывающие AI, могут не знать истинный масштаб ошибок своих систем.

«Регулирование может сыграть ключевую роль в обеспечении здоровой информационной экосистемы в эпоху AI», — пишет BBC.

Источник

Написать комментарий