OpenAI представила GPT-4o

OpenAI представила новую языковую модель GPT-4o, которая теперь ляжет в основу ChatGPT. GPT-4o может воспринимать и генерировать звук, изображение и текст и будет доступна всем пользователям бесплатно.

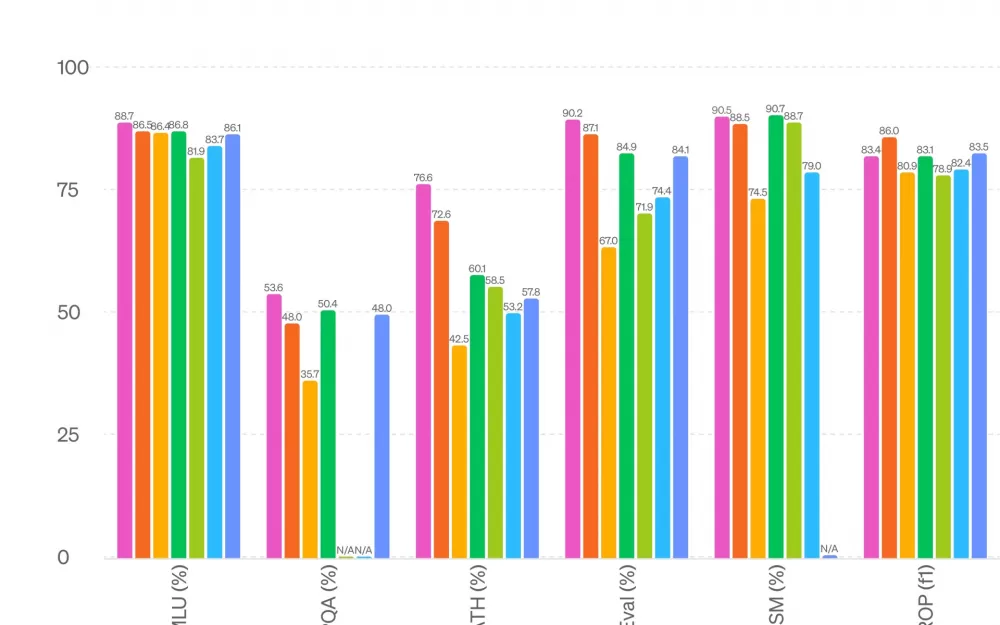

О в GPT-4o означает omni, что должно отражать универсальность её работы. Эта версия «намного быстрее» предшественниц и занимает первое место по всем тестам по сравнению с конкурентами, включая Google Gemini.

Среди особенностей модели:

может реагировать на аудиовход всего за 232 миллисекунды, в среднем 320 миллисекунд, что аналогично времени реакции человека(откроется в новом окне) в разговоре;

общается голосом «как человек», меняя интонации;

улучшенная память: модель запоминает все беседы с пользователем;

соответствует производительности GPT-4 Turbo для текста на английском языке и кода;

значительно улучшена работа с текстом не на английском языке (поддерживает 50 языков);

синтез объектов в 3D;

намного лучше воспринимает и анализирует изображения, включая графики, диаграммы и скриншоты, по сравнению с существующими моделями;

пользуется как собственными знаниями, так и данными из Интернета.

Полный список возможностей модели перечислен в посте в блоге OpenAI. В ходе демонстрации GPT-4o сотрудники OpenAI пообщались с ней голосом, продемонстрировав её умение понимать тон и направление беседы и то, как естественно она разговаривает и даже шутит. Её также попросили сымитировать типичный голос робота, с чем она также справилась.

«До GPT-4o общение с ChatGPT голосом проходило со средней задержкой в 2,8 секунды (GPT-3.5) и 5,4 секунды (GPT-4). причина заключается в том, что в этих двух моделях голосовой режим представляет собой конвейер из трёх отдельных моделей: одна простая модель транскрибирует звук в текст, GPT-3.5 или GPT-4 принимает и выводит текст, а третья простая модель преобразует этот текст обратно в аудио. Из-за этого нейросеть теряет часть информации: она не может напрямую считывать тон беседы, понимать нескольких говорящих или распознавать фоновые шумы», — напоминает OpenAI. В GPT-4o все входные и выходные данные обрабатываются одной и той же нейросетью, что убирает эти ограничения.

Согласно посту в блоге OpenAI, возможности GPT-4o «будут развёртываться постепенно начиная с сегодняшнего дня», но функции обработки текста и изображений начнут должны появиться в ChatGPT в ближайшее время. Для разработчиков новая модель доступна через API «уже сегодня», заявила технический директор OpenAI Мира Мурати. OpenAI пообещала также выпустить приложение для ПК.

В конце 2023 года OpenAI презентовала модель GPT-4 Turbo — более мощную версию ChatGPT. Она позволяет вводить промты до 128 тысяч токенов, что эквивалентно 300 страницам.

Написать комментарий