Специалисты из T‑Bank AI Research и AIRI обучили ИИ самостоятельно адаптироваться к новым действиям

Учёные из лаборатории исследований искусственного интеллекта T‑Bank AI Research и института AIRI разработали модель в области контекстного обучения , которая умеет самостоятельно обучаться новым действиям всего на нескольких примерах.

Ранее ИИ‑системы умели выполнять только фиксированный набор действий и при появлении новых задач должны были переобучаться с нуля. Это требовало дополнительных финансовых и вычислительных ресурсов, чтобы дообучить ИИ для практического применения.

Результаты исследования были представлены на международной конференции по машинному обучению ICML (International Conference on Machine Learning), которая в 2024 году проходила в 41-й раз в Вене, Австрия. Исходный код и дополнительные материалы опубликованы на GitHub.

Открытие российских учёных позволяет создавать ИИ‑системы, способные адаптироваться к изменениям внешней среды и новым задачам без участия человека. Решение поможет в различных областях: от космических аппаратов до домашних роботов‑помощников.

Разработанная российскими учёными модель, названная Headless‑AD, умеет выполнять в пять раз больше действий, чем заложено в неё при обучении. Один из потенциальных сценариев применения такой модели — создание персональных роботов‑помощников по дому. Они могут быть обучены на стандартном наборе действий и выполнять одни и те же задачи в каждом доме.

Модель Headless‑AD предполагает возможность адаптации к индивидуальному контексту и особенностям быта, что позволяет домашним роботам без переобучения осваивать новые действия, необходимые для быта каждого отдельного домохозяйства. Другой пример применения модели — адаптация беспилотного автомобиля, который будет способен работать после замены детали, даже если она имеет другой принцип работы. Например, при установке двигателя с более сильной тягой или новой шины.

Обучение в контексте (In‑Context Learning) — это одна из самых перспективных областей в сфере искусственного интеллекта. Оно позволяет ИИ‑агентам адаптироваться к новым ситуациям без необходимости повторного обучения.

Теоретически ИИ‑агенты должны уметь адаптироваться к окружающей среде по четырём компонентам:

«Состояние» (State) — то, что агент видит или знает о текущей ситуации;

«Переход» (Transition) — изменение состояния агента;

«Награда» (Reward) — оценка выполненного агентом действия, может быть положительной или отрицательной;

«Действие» (Action) — доступные агенту способы взаимодействия со средой.

Ранее ИИ-агенты умели адаптироваться по первым трём компонентам. Например, беспилотные автомобили адаптируются к меняющимся погодным условиям (State), скорости движения (Transition) и пунктам назначения (Reward). Последняя из этих компонент — адаптация по действиям (Action) — не была до конца изучена и не использовалась в создании моделей. Агенты умели выполнять только фиксированный набор действий, а при появлении новых требовали переобучения с нуля.

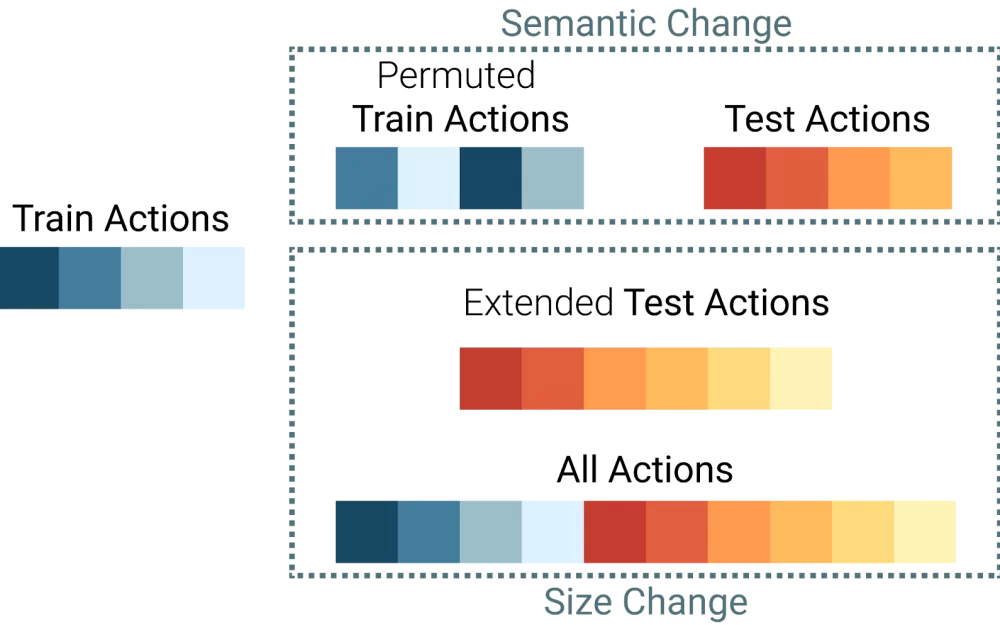

Учёные из T‑Bank AI Research и AIRI решили эту проблему, создав модель Headless‑AD, которая научилась адаптироваться к окружающей среде по действиям. Для этого они взяли за основу модель дистилляции алгоритма (Algorithm Distillation, AD), ранее самую передовую разработку в In‑Context Learning. Однако её применение ограничено только тем набором действий, что доступен на этапе обучения.

Headless‑AD была создана на основе AD с помощью трёх модификаций:

отказ от конечного линейного слоя, который ранее ограничивал количество и набор доступных действий, — отсюда название Headless‑AD;

кодировка действий случайными векторами — позволяет избежать необходимости дообучения для каждого нового действия, обеспечивая автоматическую адаптацию;

внедрение контекста, который позволяет информировать модель о доступных действиях.

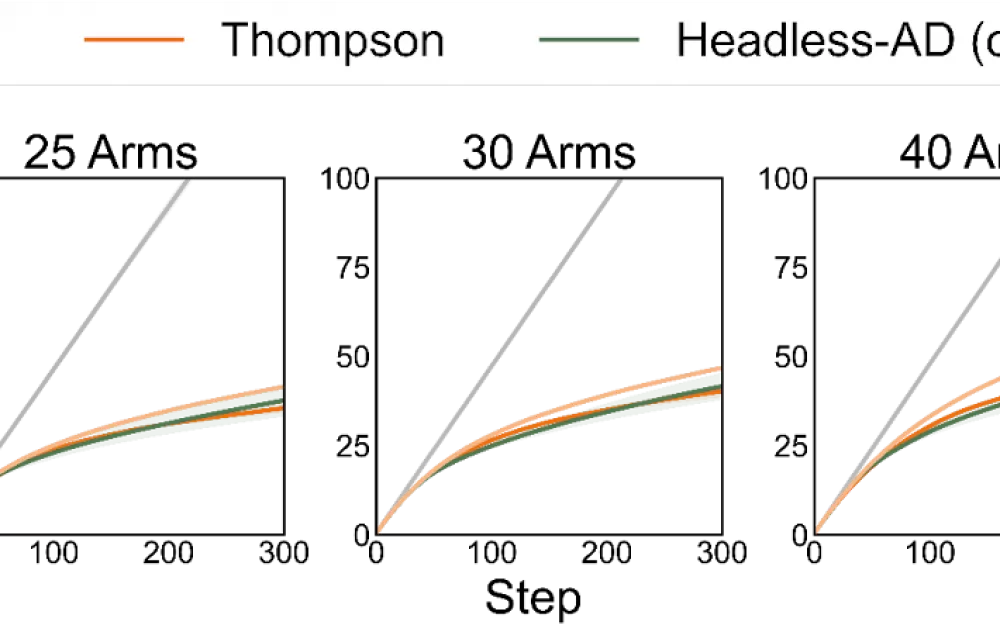

Было проведено несколько экспериментов, сравнивающих Headless‑AD и ближайшие аналоги на разных задачах. Например, в модели рекомендательных систем «Контекстуальные бандиты» задача агента — рекомендовать пользователю наиболее подходящие товары. Headless‑AD может рекомендовать в пять раз больше товаров по сравнению с тем количеством, которому ее обучали. В то время как модель AD требует переобучения для каждого нового набора товаров и не способна достигать исходного качества при увеличении их количества.

При этом адаптация Headless‑AD к новым действиям происходит без потери качества. Задача «Многорукие бандиты», где требуется найти оптимальное действие за наименьшее количество попыток, показала, что Headless‑AD работает на уровне специализированного алгоритма, созданного конкретно под эту задачу.

Другие эксперименты также подтвердили, что Headless‑AD способна к выполнению любой комбинации и количества действий, при этом сохраняя качество их выполнения и не затрачивая дополнительные вычислительные ресурсы. Это делает применение ИИ более быстрым и дешёвым.

Написать комментарий