Пентагон использовал чат-боты для управления боевыми действиями в StarCraft II

Военные США изучили возможность применения чат-ботов в планировании боевых действий в контексте военного симулятора, основанного на компьютерной стратегии StarCraft II. Они разработали новый чат-бот на базе больших языковых моделей OpenAI и сравнили его с другими чат-ботами, доступными для обычных пользователей. Военные остались довольны, а эксперты предупредили о неприятных последствиях в случае использования таких технологий в реальности. Среди таких последствий — значительные «запланированные» потери.

Американские военные уже давно изучают потенциал использования технологий искусственного интеллекта в военных действиях. Например, с помощью ИИ они проводят анализ изображений мест сражений и даже определяют цели для авиаударов. Но только недавно Пентагон стал тестировать так называемые большие языковые модели и чат-боты на их основе, которые, по мнению ряда специалистов, помогут командирам быстро адаптироваться к постоянно меняющейся обстановке на поле боя и принимать верные решения за считаные секунды.

Поясним: большие языковые модели — улучшенные модели искусственного интеллекта, которые применяют алгоритмы машинного обучения, позволяющие обобщать, прогнозировать, генерировать человеческие языки на основе больших наборов текстовых данных.

Чат-боты — компьютерная программа, которая имитирует реальный разговор с пользователем, общается с ним с помощью текстовых, графических или аудио сообщений. Поскольку чат-боты используют языковые модели, то понимают язык, а не просто команды. Таким образом, после каждого диалога они становятся умнее.

Ученые из исследовательской лаборатории сухопутных войск США рассказали о новом чат-боте COA-GPT на базе больших языковых моделей OpenAI, который специально создали для помощи командирам. Чтобы проверить эффективность виртуального помощника, исследователи сравнили его с другими чат-ботами, доступными для обычных пользователей: GPT-4 Turbo и GPT-4 Vision (также на базе OpenAI, последний может обрабатывать как текстовую, так и графическую информацию) и двумя другими чат-ботами, основанными на более старых языковых моделях. Результаты работы опубликованы на сайте электронного архива препринтов arXiv.

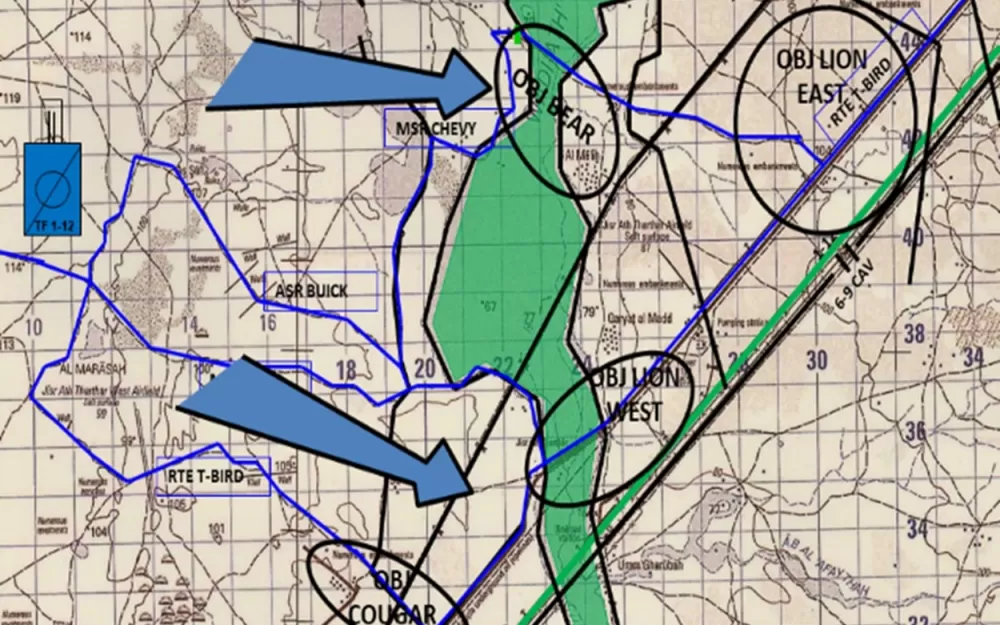

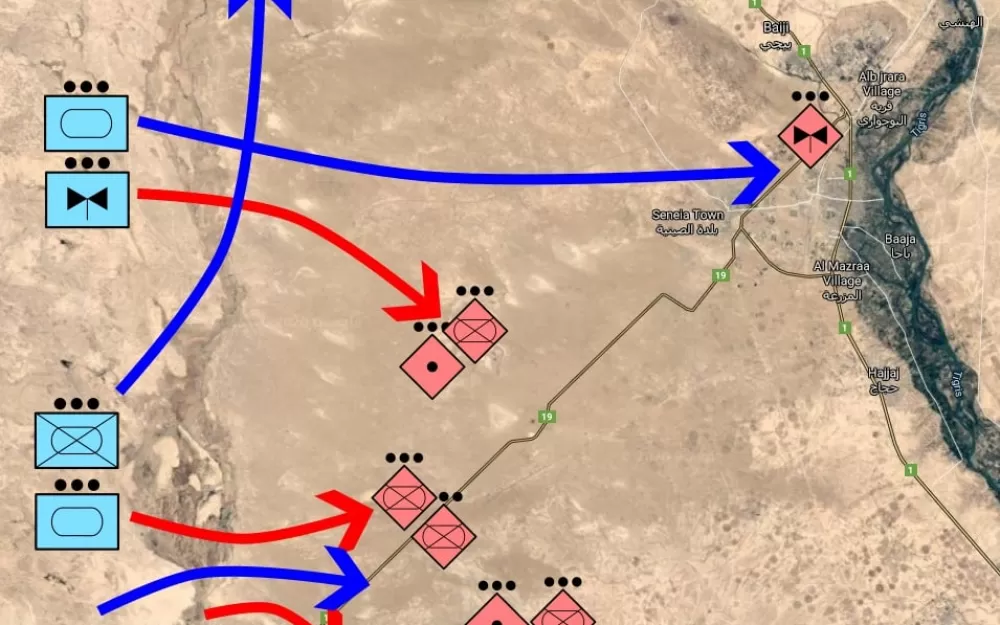

Эксперимент проходил в военном симуляторе, основанном на компьютерной игре в жанре стратегия в реальном времени StarCraft II. Все «подопытные» играли роль военных советников, они должны были спланировать и провести операцию «Коготь тигра» (TigerClaw).

Перед чат-ботами военные поставили несколько задач. Во-первых, предоставить командирам (которых играли люди) данные о местности, где развернется операция, а также подробную информацию о союзных и вражеских силах. После чего виртуальным помощникам необходимо было с наименьшими потерями переместить оперативные группы с западного берега реки на восточный через четыре моста, захватить вражеские объекты и уничтожить противника.

В качестве прототипа реальной боевой техники использовались юниты из игры. Например, танки M1A2 Abrams заменили осадными танками, а механизированную пехоту — машинами Hellion. Союзные силы состояли из девяти танковых, трех мотопехотных, одного минометного, двух авиационных и одного разведывательного подразделения. Силы противника — из 12 мотострелковых, одного авиационного, двух артиллерийских, одного противотанкового и одного пехотного подразделения.

Все пять чат-ботов принимали решения во время проведения миссии молниеносно, буквально за несколько секунд. Однако чат-боты, созданные на базе большой языковой модели OpenAI, предлагали гораздо больше вариантов действий для достижения целей, чем чат-боты, на основе старых языковых моделей. Но при выполнении задач первые гораздо чаще жертвовали техникой и живой силой, чем вторые. То есть чат-боты GPT несли больше военных потерь, чем их «старые напарники».

Что касается COA-GPT, то он успешнее других чат-ботов смог адаптироваться к новым ситуациям, возникшим во время выполнения миссии, без необходимости переподготовки, а также показал лучшие результаты во взаимодействии с командиром-человеком.

В начале 2024 года научно-исследовательская организация OpenAI — разработчик нейросети семейства GPT — обновила политику использования данных и сняла запрет на применение некоторых технологий ChatGPT в военных целях. Однако компания по-прежнему не разрешает использовать свои технологии в разработке оружия, а также для задач, предполагающих убийство людей и порчу имущества. Исследовательская лаборатория армии США не комментирует, как именно в их распоряжении оказались большие языковые модели OpenAI.

Многие эксперты скептически отнеслись к разработке американских военных. Они считают, что использовать большие языковые модели в ситуациях, когда на кону стоит многое, а решения будут иметь глобальные последствия, неправильно. Причина в том, что люди склонны слепо доверять компьютерам, даже если известно, что предлагаемые ими варианты ошибочны. Такое явление в науке называют «побочный эффект автоматизации» (automation bias).

В настоящее время военные разработки в области искусственного интеллекта ведут многие страны мира. В их числе Великобритания, Южная Корея, Европейский союз, Израиль, но лидер гонки — США. На 2024 год Министерство обороны этой страны работает над 180 проектами с ИИ для военных целей. В 2024-м Пентагон запросил у федерального правительства на эти нужды 3,2 миллиарда долларов.

Написать комментарий